NoSQL之 Redis集群-程序员宅基地

技术标签: redis

案例概述

单节点Redis服务器带来的问题

- 单点故障,服务不可用

- 无法处理大量的并发数据请求

- 数据丢失—大灾难

解决方法

- 搭建Redis集群

Redis集群知识点

Redis集群介绍

- Redis集群是一个提供在多个Redis间节点间共享数据的程序集

- Redis集群并不支持处理多个keys的命令,因为这需要在不同的节点间移动数据,从而达不到像Redis那样的性能,在高负载的情况下可能会导致不可预料的错误

- Redis集群通过分区来提供—定程度的可用性,在实际环境中当某个节点宕机或者不可达的情况下可继续处理命令

Redis集群的优势

- 自动分割数据到不同的节点上

- 整个集群的部分节点失败或者不可达的情况下能够继续处理命令

Redis集群的实现方法

- 有客户端分片

- 代理分片

- 服务器端分片

Redis-Cluster数据分片

1:Redis集群没有使用一致性hash,而是引入了哈希槽概念

2:Redis 集群有16384个哈希槽

3:每个key通过CRC16校验后对16384取模来决定放置槽

4:集群的每个节点负责一部分哈希槽

5:以3个节点组成的集群为例

- 节点A包含0到5500号哈希槽

- 节点B包含5501到11000号哈希槽

- 节点C包含11001到16383号哈希槽支持添加或者删除节点

6:添加删除节点无需停止服务

- 如果想新添加个节点D,需要移动节点A,B,C中的部分槽到D上

- 如果想移除节点A,需要将A中的槽移到B和C节点上,再将没有任何槽的A节点从集群中移除

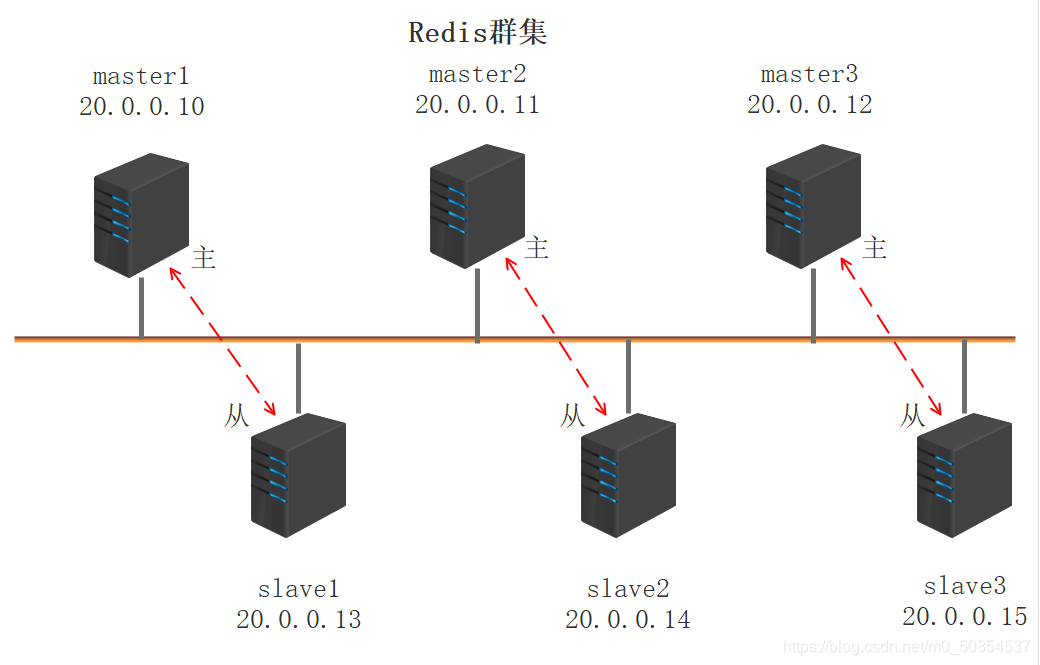

Redis-Cluster的主从复制模型

- 集群中具有A,B,C三个节点,如果节点B失败了,整个集群就会因缺少5501-11000这个范围的槽而不可用

- 为每个节点添加一个从节点A1,B1,C1,整个集群便有三个master节点和三个slave节点组成在节点B失败后,集群便会选举B1为新的主节点继续服务

- 当B和B1都失败后,集群将不可用

案例拓扑图

具体步骤

1:每台服务器导入redis软件包,其中一台主redis要有群集文件

2:解压缩redis软件包,6台服务器同步操作

[root@redis1 ~]# tar zxvf redis-5.0.4.tar.gz3:配置安装,6台服务器同步操作

[root@redis1 ~]# cd redis-5.0.4/

[root@redis1 redis-5.0.4]# make

[root@redis1 redis-5.0.4]# make PREFIX=/usr/local/redis install4:链接快捷命令,6台服务器同步操作

[root@redis1 ~]# ln -s /usr/local/redis/bin/* /usr/local/bin/5:设置Redis相关配置文件,6台服务器同步操作

[root@redis1 ~]# cd redis-5.0.4/utils/

[root@redis1 utils]# ./install_server.sh

[root@redis1 utils]# netstat -anptu | grep redis

tcp 0 0 127.0.0.1:6379 0.0.0.0:* LISTEN 59531/redis-server 6:修改主配置文件,6台服务器同步操作

[root@slave3 ~]# vi /etc/redis/6379.conf

cluster-enabled yes

appendonly yes

cluster-config-file nodes-6379.conf

cluster-node-timeout 15000

cluster-require-full-coverage yes修改IP地址需要每台服务器单独修改

[root@redis1 ~]# vi /etc/redis/6379.conf

bind 20.0.0.10[root@redis2 ~]# vi /etc/redis/6379.conf

bind 20.0.0.11[root@redis3 ~]# vi /etc/redis/6379.conf

bind 20.0.0.12[root@slave1 ~]# vi /etc/redis/6379.conf

bind 20.0.0.13[root@slave2 ~]# vi /etc/redis/6379.conf

bind 20.0.0.14[root@slave3 ~]# vi /etc/redis/6379.conf

bind 20.0.0.157:重启服务,6台服务器同步操作

[root@redis1 ~]# /etc/init.d/redis_6379 restart

Stopping ...

Waiting for Redis to shutdown ...

Redis stopped

Starting Redis server...

[root@redis1 ~]# netstat -anptu | grep redis8:在20.0.0.10服务器上,使用脚本创建群集

[root@redis1 ~]# yum -y install ruby rubygems

[root@redis1 ~]# gem install redis-3.2.0.gem9:建立群集

[root@redis1 ~]# redis-cli --cluster create --cluster-replicas 1 20.0.0.10:6379 20.0.0.11:6379 20.0.0.12:6379 20.0.0.13:6379 20.0.0.14:6379 20.0.0.15:6379

>>> Performing hash slots allocation on 6 nodes...

Master[0] -> Slots 0 - 5460

Master[1] -> Slots 5461 - 10922

Master[2] -> Slots 10923 - 16383

Adding replica 20.0.0.14:6379 to 20.0.0.10:6379

Adding replica 20.0.0.15:6379 to 20.0.0.11:6379

Adding replica 20.0.0.13:6379 to 20.0.0.12:6379

M: 2ce100a99c214bfac23ae1c31b8068e93506615b 20.0.0.10:6379

slots:[0-5460] (5461 slots) master

M: 5f5ff79b9301f10e175aea6604ff80372d6c97a8 20.0.0.11:6379

slots:[5461-10922] (5462 slots) master

M: a6234f074de2ee05b4f7c1ba96c8a3e084104dd4 20.0.0.12:6379

slots:[10923-16383] (5461 slots) master

S: b378987085da43974359cb02bcbc9443e808bb13 20.0.0.13:6379

replicates a6234f074de2ee05b4f7c1ba96c8a3e084104dd4

S: 5d27b053b2607dfed82f79d29aa2e5c3b8846bc2 20.0.0.14:6379

replicates 2ce100a99c214bfac23ae1c31b8068e93506615b

S: 1d2b8d8fd38f5e7c2dce00ee43e13f162a18508d 20.0.0.15:6379

replicates 5f5ff79b9301f10e175aea6604ff80372d6c97a8

Can I set the above configuration? (type 'yes' to accept): yes

>>> Nodes configuration updated

>>> Assign a different config epoch to each node

>>> Sending CLUSTER MEET messages to join the cluster

Waiting for the cluster to join

..

>>> Performing Cluster Check (using node 20.0.0.10:6379)

M: 2ce100a99c214bfac23ae1c31b8068e93506615b 20.0.0.10:6379

slots:[0-5460] (5461 slots) master

1 additional replica(s)

M: a6234f074de2ee05b4f7c1ba96c8a3e084104dd4 20.0.0.12:6379

slots:[10923-16383] (5461 slots) master

1 additional replica(s)

S: 1d2b8d8fd38f5e7c2dce00ee43e13f162a18508d 20.0.0.15:6379

slots: (0 slots) slave

replicates 5f5ff79b9301f10e175aea6604ff80372d6c97a8

S: b378987085da43974359cb02bcbc9443e808bb13 20.0.0.13:6379

slots: (0 slots) slave

replicates a6234f074de2ee05b4f7c1ba96c8a3e084104dd4

M: 5f5ff79b9301f10e175aea6604ff80372d6c97a8 20.0.0.11:6379

slots:[5461-10922] (5462 slots) master

1 additional replica(s)

S: 5d27b053b2607dfed82f79d29aa2e5c3b8846bc2 20.0.0.14:6379

slots: (0 slots) slave

replicates 2ce100a99c214bfac23ae1c31b8068e93506615b

[OK] All nodes agree about slots configuration.

>>> Check for open slots...

>>> Check slots coverage...

[OK] All 16384 slots covered.10:测试群集

登录写入一个数据

[root@redis1 ~]# redis-cli -h 20.0.0.10 -p 6379 -c

20.0.0.10:6379> set aaa 111

-> Redirected to slot [10439] located at 20.0.0.11:6379

OK另一台主服务器获取数据

[root@redis3 ~]# redis-cli -h 20.0.0.13 -p 6379 -c

20.0.0.13:6379> get aaa

-> Redirected to slot [10439] located at 20.0.0.11:6379

"111"登录不同服务器获取数据

[root@redis2 ~]# redis-cli -h 20.0.0.13 -p 6379 -c

20.0.0.13:6379> get aaa

-> Redirected to slot [10439] located at 20.0.0.11:6379

"111"查看集群状态

20.0.0.11:6379> cluster info

cluster_state:ok

cluster_slots_assigned:16384

cluster_slots_ok:16384

cluster_slots_pfail:0

cluster_slots_fail:0

cluster_known_nodes:6

cluster_size:3

cluster_current_epoch:6

cluster_my_epoch:2

cluster_stats_messages_ping_sent:5018

cluster_stats_messages_pong_sent:4927

cluster_stats_messages_meet_sent:2

cluster_stats_messages_sent:9947

cluster_stats_messages_ping_received:4923

cluster_stats_messages_pong_received:5020

cluster_stats_messages_meet_received:4

cluster_stats_messages_received:9947查看节点状态

20.0.0.11:6379> cluster nodes

5d27b053b2607dfed82f79d29aa2e5c3b8846bc2 20.0.0.14:6379@16379 slave 2ce100a99c214bfac23ae1c31b8068e93506615b 0 1608200801776 1 connected

b378987085da43974359cb02bcbc9443e808bb13 20.0.0.13:6379@16379 slave a6234f074de2ee05b4f7c1ba96c8a3e084104dd4 0 1608200799000 3 connected

a6234f074de2ee05b4f7c1ba96c8a3e084104dd4 20.0.0.12:6379@16379 master - 0 1608200801000 3 connected 10923-16383

1d2b8d8fd38f5e7c2dce00ee43e13f162a18508d 20.0.0.15:6379@16379 slave 5f5ff79b9301f10e175aea6604ff80372d6c97a8 0 1608200802783 6 connected

5f5ff79b9301f10e175aea6604ff80372d6c97a8 20.0.0.11:6379@16379 myself,master - 0 1608200801000 2 connected 5461-10922

2ce100a99c214bfac23ae1c31b8068e93506615b 20.0.0.10:6379@16379 master - 0 1608200801000 1 connected 0-546011:宕机测试

主服务器停止服务

[root@redis1 ~]# pkill redis查看状态

20.0.0.11:6379> cluster nodes

5d27b053b2607dfed82f79d29aa2e5c3b8846bc2 20.0.0.14:6379@16379 slave 2ce100a99c214bfac23ae1c31b8068e93506615b 0 1608201296530 1 connected

b378987085da43974359cb02bcbc9443e808bb13 20.0.0.13:6379@16379 slave a6234f074de2ee05b4f7c1ba96c8a3e084104dd4 0 1608201297542 3 connected

a6234f074de2ee05b4f7c1ba96c8a3e084104dd4 20.0.0.12:6379@16379 master - 0 1608201298547 3 connected 10923-16383

1d2b8d8fd38f5e7c2dce00ee43e13f162a18508d 20.0.0.15:6379@16379 slave 5f5ff79b9301f10e175aea6604ff80372d6c97a8 0 1608201299558 6 connected

5f5ff79b9301f10e175aea6604ff80372d6c97a8 20.0.0.11:6379@16379 myself,master - 0 1608201294000 2 connected 5461-10922

2ce100a99c214bfac23ae1c31b8068e93506615b 20.0.0.10:6379@16379 master,fail - 1608201280782 1608201277358 1 disconnected 0-5460

备份20.0.0.15以上线智能推荐

hive使用适用场景_大数据入门:Hive应用场景-程序员宅基地

文章浏览阅读5.8k次。在大数据的发展当中,大数据技术生态的组件,也在不断地拓展开来,而其中的Hive组件,作为Hadoop的数据仓库工具,可以实现对Hadoop集群当中的大规模数据进行相应的数据处理。今天我们的大数据入门分享,就主要来讲讲,Hive应用场景。关于Hive,首先需要明确的一点就是,Hive并非数据库,Hive所提供的数据存储、查询和分析功能,本质上来说,并非传统数据库所提供的存储、查询、分析功能。Hive..._hive应用场景

zblog采集-织梦全自动采集插件-织梦免费采集插件_zblog 网页采集插件-程序员宅基地

文章浏览阅读496次。Zblog是由Zblog开发团队开发的一款小巧而强大的基于Asp和PHP平台的开源程序,但是插件市场上的Zblog采集插件,没有一款能打的,要么就是没有SEO文章内容处理,要么就是功能单一。很少有适合SEO站长的Zblog采集。人们都知道Zblog采集接口都是对Zblog采集不熟悉的人做的,很多人采取模拟登陆的方法进行发布文章,也有很多人直接操作数据库发布文章,然而这些都或多或少的产生各种问题,发布速度慢、文章内容未经严格过滤,导致安全性问题、不能发Tag、不能自动创建分类等。但是使用Zblog采._zblog 网页采集插件

Flink学习四:提交Flink运行job_flink定时运行job-程序员宅基地

文章浏览阅读2.4k次,点赞2次,收藏2次。restUI页面提交1.1 添加上传jar包1.2 提交任务job1.3 查看提交的任务2. 命令行提交./flink-1.9.3/bin/flink run -c com.qu.wc.StreamWordCount -p 2 FlinkTutorial-1.0-SNAPSHOT.jar3. 命令行查看正在运行的job./flink-1.9.3/bin/flink list4. 命令行查看所有job./flink-1.9.3/bin/flink list --all._flink定时运行job

STM32-LED闪烁项目总结_嵌入式stm32闪烁led实验总结-程序员宅基地

文章浏览阅读1k次,点赞2次,收藏6次。这个项目是基于STM32的LED闪烁项目,主要目的是让学习者熟悉STM32的基本操作和编程方法。在这个项目中,我们将使用STM32作为控制器,通过对GPIO口的控制实现LED灯的闪烁。这个STM32 LED闪烁的项目是一个非常简单的入门项目,但它可以帮助学习者熟悉STM32的编程方法和GPIO口的使用。在这个项目中,我们通过对GPIO口的控制实现了LED灯的闪烁。LED闪烁是STM32入门课程的基础操作之一,它旨在教学生如何使用STM32开发板控制LED灯的闪烁。_嵌入式stm32闪烁led实验总结

Debezium安装部署和将服务托管到systemctl-程序员宅基地

文章浏览阅读63次。本文介绍了安装和部署Debezium的详细步骤,并演示了如何将Debezium服务托管到systemctl以进行方便的管理。本文将详细介绍如何安装和部署Debezium,并将其服务托管到systemctl。解压缩后,将得到一个名为"debezium"的目录,其中包含Debezium的二进制文件和其他必要的资源。注意替换"ExecStart"中的"/path/to/debezium"为实际的Debezium目录路径。接下来,需要下载Debezium的压缩包,并将其解压到所需的目录。

Android 控制屏幕唤醒常亮或熄灭_android实现拿起手机亮屏-程序员宅基地

文章浏览阅读4.4k次。需求:在诗词曲文项目中,诗词整篇朗读的时候,文章没有读完会因为屏幕熄灭停止朗读。要求:在文章没有朗读完毕之前屏幕常亮,读完以后屏幕常亮关闭;1.权限配置:设置电源管理的权限。

随便推点

目标检测简介-程序员宅基地

文章浏览阅读2.3k次。目标检测简介、评估标准、经典算法_目标检测

记SQL server安装后无法连接127.0.0.1解决方法_sqlserver 127 0 01 无法连接-程序员宅基地

文章浏览阅读6.3k次,点赞4次,收藏9次。实训时需要安装SQL server2008 R所以我上网上找了一个.exe 的安装包链接:https://pan.baidu.com/s/1_FkhB8XJy3Js_rFADhdtmA提取码:ztki注:解压后1.04G安装时Microsoft需下载.NET,更新安装后会自动安装如下:点击第一个傻瓜式安装,唯一注意的是在修改路径的时候如下不可修改:到安装实例的时候就可以修改啦数据..._sqlserver 127 0 01 无法连接

js 获取对象的所有key值,用来遍历_js 遍历对象的key-程序员宅基地

文章浏览阅读7.4k次。1. Object.keys(item); 获取到了key之后就可以遍历的时候直接使用这个进行遍历所有的key跟valuevar infoItem={ name:'xiaowu', age:'18',}//的出来的keys就是[name,age]var keys=Object.keys(infoItem);2. 通常用于以下实力中 <div *ngFor="let item of keys"> <div>{{item}}.._js 遍历对象的key

粒子群算法(PSO)求解路径规划_粒子群算法路径规划-程序员宅基地

文章浏览阅读2.2w次,点赞51次,收藏310次。粒子群算法求解路径规划路径规划问题描述 给定环境信息,如果该环境内有障碍物,寻求起始点到目标点的最短路径, 并且路径不能与障碍物相交,如图 1.1.1 所示。1.2 粒子群算法求解1.2.1 求解思路 粒子群优化算法(PSO),粒子群中的每一个粒子都代表一个问题的可能解, 通过粒子个体的简单行为,群体内的信息交互实现问题求解的智能性。 在路径规划中,我们将每一条路径规划为一个粒子,每个粒子群群有 n 个粒 子,即有 n 条路径,同时,每个粒子又有 m 个染色体,即中间过渡点的_粒子群算法路径规划

量化评价:稳健的业绩评价指标_rar 海龟-程序员宅基地

文章浏览阅读353次。所谓稳健的评估指标,是指在评估的过程中数据的轻微变化并不会显著的影响一个统计指标。而不稳健的评估指标则相反,在对交易系统进行回测时,参数值的轻微变化会带来不稳健指标的大幅变化。对于不稳健的评估指标,任何对数据有影响的因素都会对测试结果产生过大的影响,这很容易导致数据过拟合。_rar 海龟

IAP在ARM Cortex-M3微控制器实现原理_value line devices connectivity line devices-程序员宅基地

文章浏览阅读607次,点赞2次,收藏7次。–基于STM32F103ZET6的UART通讯实现一、什么是IAP,为什么要IAPIAP即为In Application Programming(在应用中编程),一般情况下,以STM32F10x系列芯片为主控制器的设备在出厂时就已经使用J-Link仿真器将应用代码烧录了,如果在设备使用过程中需要进行应用代码的更换、升级等操作的话,则可能需要将设备返回原厂并拆解出来再使用J-Link重新烧录代码,这就增加了很多不必要的麻烦。站在用户的角度来说,就是能让用户自己来更换设备里边的代码程序而厂家这边只需要提供给_value line devices connectivity line devices