【实验记录】U-Net训练自己的数据集(Keras)_自定义数据集训练u-net-程序员宅基地

技术标签: # U-Net tensorflow 深度学习 keras

论文地址:https://arxiv.org/abs/1505.04597

代码地址:https://github.com/zhixuhao/unet

环境配置

CUDA 8.0

cuDNN

Tensorflow 1.2.1

Keras 2.0.6

Python 3.5

# 创建虚拟环境

conda create -n u-net python=3.5

conda activate u-net

# 安装依赖

pip install tensorflow-gpu==1.2.1

pip install keras==2.0.6

pip install scikit-image

conda install numpy

conda install h5py

代码说明

可以运行一下代码中自带的数据集 membrane 看看:

python main.py

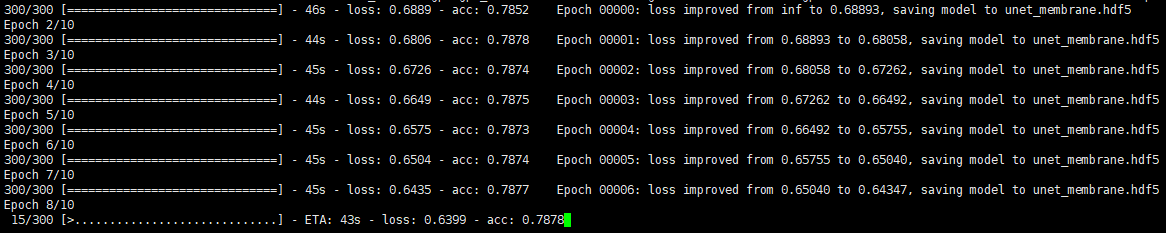

正常训练的话是这个样子:

main.py 是执行训练的主文件,其中:

data_gen_args定义了数据扩充操作trainGenerator前四个参数分别为 1)训练的 batch_size,2)训练文件的主路径,3)训练图像的文件夹名称,4)训练图像对应标签的文件夹名称,接下来分别是 5)数据扩充操作,6、7)图像、标签的色彩模式,8、9)图像、标签的保存路径,10)是否多类别,11)类别个数(num_class 大于 2 的就属于多类别,flag 就应该设置为 True),12)是否保存,13)图片大小

训练 & 测试

1. 准备数据文件

在 ~/unet-master/data 下创建自己的数据集文件夹,比如 mydata。在 mydata 下创建 train 和 test 文件夹用于存放训练和测试数据。其中 train/image 和 train/label 中分别存放训练图像和对应的标签。test 下直接放所有测试图像即可。

2. 修改主文件 main.py

(1)修改训练文件路径及 batch size

myGene = trainGenerator(10,'data/mydata/train','image','label',data_gen_args,save_to_dir = None)

- 参数分别为 batch size(这里设为了 10),训练图像根目录,训练图像文件夹,训练图像对应标签文件夹

(2)修改 checkpoint 保存名称

model_checkpoint = ModelCheckpoint('unet_mydata.hdf5', monitor='loss',verbose=1, save_best_only=True)

(3)修改训练 epoch

model.fit_generator(myGene,steps_per_epoch=80,epochs=100,callbacks=[model_checkpoint],class_weight={

1,245,245,245})

steps_per_epoch是每个 epoch 要迭代多少次,比如训练图像有 800 张,设训练 batch 为 10 的话,steps 就是 800 / 10 = 80;epochs为训练的 epoch 数,这里设为了 100;

(4)修改测试路径

testGene = testGenerator("data/mydata/test")

# 测试图片有 400 张

results = model.predict_generator(testGene,400,verbose=1)

saveResult("data/mydata/test",results)

3. 执行训练 & 测试

python main.py

另外,使用自己定义的 loss 函数,就在 model.py 修改使用的 loss 函数

model.compile(optimizer = Adam(lr = 1e-4), loss = 'ACLoss', metrics = ['accuracy'])

然后相应地,通过上面的 compile 找到了损失函数定义的 losses.py 文件,把自己的 loss 函数加进去就可以啦,输入参数为 (y_pred, y_true)

4. 多类别训练

源代码训练单类别,也就是只有前景(1)和背景(0)时没有问题,但是在进行多类别分割时报错:

ValueError: Error when checking target: expected conv2d_24 to have 4 dimensions, but got array with shape (5, 65536, 4)

原因:查了下原因是这个代码不适用于多类分割任务,参考了这篇文章,对代码做出修改。

解决:

(1)修改数据处理文件 data.py

def adjustData(img,mask,flag_multi_class,num_class):

if(flag_multi_class):

img = img / 255

mask = mask[:,:,:,0] if(len(mask.shape) == 4) else mask[:,:,0]

new_mask = np.zeros(mask.shape + (num_class,))

for i in range(num_class):

#for one pixel in the image, find the class in mask and convert it into one-hot vector

#index = np.where(mask == i)

#index_mask = (index[0],index[1],index[2],np.zeros(len(index[0]),dtype = np.int64) + i) if (len(mask.shape) == 4) else (index[0],index[1],np.zeros(len(index[0]),dtype = np.int64) + i)

#new_mask[index_mask] = 1

new_mask[mask == i,i] = 1

# 对这里进行了修改

new_mask = np.reshape(new_mask,(new_mask.shape[0],new_mask.shape[1],new_mask.shape[2],new_mask.shape[3])) if flag_multi_class else np.reshape(new_mask,(new_mask.shape[0]*new_mask.shape[1],new_mask.shape[2]))

mask = new_mask

elif(np.max(img) > 1):

img = img / 255

mask = mask /255

mask[mask > 0.5] = 1

mask[mask <= 0.5] = 0

return (img,mask)

(2)修改模型文件 model.py 第大约第 53 行,因为报错中的 conv2d_24 实际就是 conv10,这里第一个参数 1 就是我们的类别数,将其修改为自己的类别数量即可。

# 将源代码:

conv10 = Conv2D(1, 1, activation = 'sigmoid')(conv9)

# 修改为:

conv10 = Conv2D(4, 1, activation = 'sigmoid')(conv9)

(3)修改损失函数:源代码使用的是二元交叉熵,不适用于多类别分割问题,故这里改为 Dice loss。

# data.py line 39

new_mask = np.reshape(new_mask,(new_mask.shape[0],new_mask.shape[1],new_mask.shape[2],new_mask.shape[3])) if flag_multi_class else np.reshape(new_mask,(new_mask.shape[0]*new_mask.shape[1],new_mask.shape[2]))

# model.py line 53

conv10 = Conv2D(4, 1, activation = 'sigmoid')(conv9)

报错记录与解决

【1】 ImportError: cannot import name 'tf_utils'

原因:keras 和 tensorflow 版本不兼容。

解决:tensorflow 1.2.1 和 keras 2.0.6 是 OK 的。

pip install tensorflow-gpu==1.2.1

pip install keras==2.0.6

=========================================================

【2】ImportError: `save_model` requires h5py

解决:安装 h5py:conda install h5py

=========================================================

【3】 tensorflow.python.framework.errors_impl.InternalError: Blas GEMM launch failed

原因:GPU 被占用

解决:确保一下 GPU 足够用呀~

=========================================================

【4】

Traceback (most recent call last):

File "main.py", line 21, in <module>

results = model.predict_generator(testGene,30,verbose=1)

File "/data/zyy/usr/local/anaconda3/envs/u-net/lib/python3.5/site-packages/keras/legacy/interfaces.py", line 87, in wrapper

return func(*args, **kwargs)

File "/data/zyy/usr/local/anaconda3/envs/u-net/lib/python3.5/site-packages/keras/engine/training.py", line 2067, in predict_generator

generator_output = next(output_generator)

StopIteration

Traceback (most recent call last):

File "/data/zyy/usr/local/anaconda3/envs/u-net/lib/python3.5/threading.py", line 914, in _bootstrap_inner

self.run()

File "/data/zyy/usr/local/anaconda3/envs/u-net/lib/python3.5/threading.py", line 862, in run

self._target(*self._args, **self._kwargs)

File "/data/zyy/usr/local/anaconda3/envs/u-net/lib/python3.5/site-packages/keras/utils/data_utils.py", line 560, in data_generator_task

generator_output = next(self._generator)

StopIteration

原因不知道,参考以下回答:

[1] https://github.com/zhixuhao/unet/issues/130

[2] https://stackoverflow.com/questions/46302911/what-raises-stopiteration-in-mine-keras-model-fit-generator

解决:

(1)根据 2067 行的报错,找到 training.py 代码中第 2003 行,将 max_queue_size 设置为 1

def predict_generator(self, generator, steps,

max_queue_size=1, # modified

workers=1,

use_multiprocessing=False,

verbose=0):

=========================================================

【5】 Lossy conversion from float32 to uint8. Range [0, 1]. Convert image to uint8 prior to saving to suppress this warning.

原因:关于精度的警告,就是说从 float32 直接保存为 uint8 类型可能会损失精度。参考:https://www.jianshu.com/p/84b825b9e8a3

解决:将 image 转换为 uint8 类型。修改 data.py 最后的保存函数:

from skimage import img_as_ubyte

def saveResult(save_path,npyfile,flag_multi_class = False,num_class = 2):

for i,item in enumerate(npyfile):

img = labelVisualize(num_class,COLOR_DICT,item) if flag_multi_class else item[:,:,0]

io.imsave(os.path.join(save_path,"%d_predict.png"%i),img_as_ubyte(img)) # modified

不过仍然会报一个警告,总比每张图片都有警告好

UserWarning: Possible precision loss when converting from float32 to uint8 .format(dtypeobj_in, dtypeobj_out))

=========================================================

智能推荐

react学习总结6--构建工具Gulp、Browserify(二)_react gulp-程序员宅基地

文章浏览阅读1k次。react 学习总结–构建工具Gulp、Browserify(二)1.html 文件处理gulp-htmlmin 插件 用于压缩html,可以进行配置,下边是配置信息(选填) var gulp = require('gulp'), htmlmin = require('gulp-htmlmin'); gulp.task('htmlmin', function ()_react gulp

开关电源输入:共模电感,X电容,Y电容,差摸电感理论计算!_共模电感和y电容在滤波方面的区别-程序员宅基地

文章浏览阅读7.6k次,点赞3次,收藏69次。转自:https://mp.weixin.qq.com/s/qp_DSBGKdjNo2-lO2s5v7Q引言在开关电源中,EMI滤波器对共模和差模传导噪声的抑制起着显著的作用。在研究滤波器原理的基础上,探讨了一种对共模、差模信号进行独立分析,分别建模的方法,最后基于此提出了一种EMI滤波器的设计程序。高频开关电源由于其在体积、重量、功率密度、效率等方面的诸多优点,已经被广泛地应用于工业..._共模电感和y电容在滤波方面的区别

IntelliJ IDEA 设置注释模板 (Mac)_mac idea 设置注解格式-程序员宅基地

文章浏览阅读7.9k次。类注释模板设置:点击 preferences ,搜索 File and Code Template ,在 Files tab 页下,选择 Class,在类名上面添加模板:/** * @program ${PROJECT_NAME} * @description: ${TODO} * @author: ${USER} * @create: ${YEAR}/${MONTH}/${DAY}..._mac idea 设置注解格式

sizeof用法 _sizeof(4.0+2)-程序员宅基地

文章浏览阅读2k次。Sizeof用法本文主要包括二个部分,第一部分重点介绍在VC中,怎么样采用sizeof来求结构的大小,以及容易出现的问题,并给出解决问题的方法,第二部分总结出VC中sizeof的主要用法。1、 sizeof应用在结构上的情况请看下面的结构:struct MyStruct{double dda1;char dda;int type};对结构MyStruct采用_sizeof(4.0+2)

阅读小结:Large-Margin Softmax Loss for Convolutional Neural Networks_large-margin softmax loss的代码-程序员宅基地

文章浏览阅读2.2k次,点赞3次,收藏4次。徐博最近一直在看我博客,肯定是想看我什么时候不更新,然后好嘲笑我。当然,不排除徐博已经爱上我的可能。What:改进SoftmaxLoss,显式的控制类内的距离,(不让 已经对的样本score太高,影响训练)可以防止过拟合。回顾SoftmaxLoss:1. Softmax 就是一个把一个向量归一的函数,输出也是向量。在matlab里就3行代码:% X_large-margin softmax loss的代码

后端java解析复杂嵌套json_java 解析复杂类型的json-程序员宅基地

文章浏览阅读6.2k次。其实不是很复杂百度翻译传过来的json数据:{"from":"zh","to":"en","trans_result":[{"src":"高度600米","dst":"Height 600 meters"}]}现在要取出dst对应的值:Height 600 meters String date="{"from":"zh","to":"en","trans_result":[_java 解析复杂类型的json

随便推点

如何高效地从BAM文件中提取fastq-程序员宅基地

文章浏览阅读1.8k次。在一年前,我写过一篇文章,叫做如何从BAM文件中提取fastq,之前也发现了从BAM里面提取Fastq是有些麻烦,只不过最后通过samtools的子命令实现了数据提取,实现功能之后也没有再去思考如何提高效率。最近读到每周文献-190419-植物单细胞BAM重比对以及假基因研究时,发现里面提到了一个工具叫做 bazam, 功能就是提取Fastq文件,文章发表在 Genome Bio..._10x 开发的工具 bamtofastq

中国电信天翼宽带无线路由器设置wifi笔记_中国电信wifi设置时间-程序员宅基地

文章浏览阅读8k次。0x00 前言 还记得电信天翼宽带吗?现在的天翼宽带的终端基本是华为的无限路由了,相信有不少同学在包装了中国电信天翼宽带后,个人申请到一个账号/密码,并且额外缴费得到一个路由器,然后就没有然后了。心里就纳闷,咋上wifi,然后又得另外花钱买个无线路由,然后不知道怎样弄。0x01 电信宽带的路由终端首先电信的华为路由器的底部都会贴有该终端的信息,例如终端登录地址,账号,密码等_中国电信wifi设置时间

让VC编译出来的程序不依赖于msvcr80.dll/msvcr90.dll/msvcr100.dll等文件_编译msvc不依赖msvcr100.dll-程序员宅基地

文章浏览阅读853次。让VC编译出来的程序不依赖于msvcr80.dll/msvcr90.dll/msvcr100.dll等文件正常情况下,当我们用VC编译出一个Console/Win32类型项目的exe程序时(这里暂不考虑MFC程序),会依赖于msvcrxx.dll文件(xx为不同VC对应的版本号,VC2005为80,VC2008为90,VC2010为100),发布程序的时候,就需要把对应的dll也cop_编译msvc不依赖msvcr100.dll

什么是问题?_问题是什么-程序员宅基地

文章浏览阅读4.6k次。今天看到一篇文章,说什么是问题?看到这个标题很好奇。就点进去看了一下。以下是总结和思考。漫漫人生中,我们总会遇到各种各样的问题。那么什么是问题呢?有以下一个定义:问题是目标与现状的差异。解决方案,就是现状到目标的路径。那么,什么是目标呢?目标应该是符合真实的需求。那么,什么是需求呢?需求不仅包含当前这个问题,有时候它更需要考虑到整个系统。打个比方说,有一天某个系统出现了超时问题,..._问题是什么

java中controller,service,serviceImpl,mapper,xml等几个文件的作用理解,以简单的查询为例_serviceimpl类的作用是什么-程序员宅基地

文章浏览阅读5.3w次,点赞59次,收藏278次。说明:最近一周都在写报表,样式很统一,上面是查询条件,下面是查询结果,页面如下图所示。由于要写很多报表,都是重复的工作,所以部门里的小哥哥在写了一个基于node的小程序,直接配置JSON文件,就可以生成报表模板,感觉很强(后面想学习一下)。作为一个优秀的CV工程师(复制粘贴),我也没怎么写前端的工作,直接用生成的模板就好了,但是后台的查询我还是稍微走心的。由于JAVA基础不是很好,总结的可..._serviceimpl类的作用是什么

java开发注释规范,开发人员代码注释规范.doc-程序员宅基地

文章浏览阅读111次。开发人员代码注释规范开发人员代码注释规范Java类版权及代码注释注释示例package java.blah;import java.blah.blahdy.BlahBlah;/** ==========================================================* Version Author Date Des..._huangzhihui java