【Python数据分析】数据挖掘建模——分类与预测——决策树_决策树分类python-程序员宅基地

决策树是一种树状结构,它的每一个叶节点对应着一个分类,非叶节点对应着在某个属性上的划分,根据样本在该属性上的不同取值将其划分成若干个子集。构造决策树的核心问题是在每一步如何选择适当的属性对样本做拆分。

常见的决策树算法如下:

| 决策树算法 | 算法描述 |

| ID3算法 | 在决策树各级节点上,使用信息增益的方法作为属性的选择标准 |

| C4.5算法 | ID3的改进版,使用信息增益率来选择节点属性。ID3只适用于离散的描述属性,而C4.5算法既能够处理离散的描述属性,也可以处理连续的描述属性 |

| CART算法 | 通过构建树、修剪树、评估树来构建一个二叉树。当终节点为连续变量时,该树为回归树,当终节点是分类变量时,该树为分类树 |

一、信息熵与信息增益

pi一般可以用某一类下面的样本数/总样本数来估计(si/s)

pi一般可以用某一类下面的样本数/总样本数来估计(si/s)

更具体的介绍可以参考:机器学习实战(三)——决策树_呆呆的猫的博客-程序员宅基地_决策树

二、ID3算法

ID3算法基于信息熵来选择最佳测试属性。它选择当前样本集中具有最大信息增益值的属性作为测试属性;样本集的划分则依据测试属性的取值进行,测试属性有多少不同取值就将样本集划分为多少子样本集,同时决策树上与该样本集相应的节点长出新的叶子节点。

1.ID3具体实现步骤:

(1)对当前样本集合,计算所有属性的信息增益;

(2)选择信息增益最大的属性作为测试属性,把测试属性取值相同的样本划分为同一子样本集;

(3)若子样本集的类别属性只含有单个属性,则分支为叶子节点,判断其属性值并标上相应符号,然后返回调用处;否则对子样本集递归调用本算法。

2.在Python中实现ID3决策树算法:

import pandas as pd

filename = './Python数据分析与挖掘实战(第2版)/chapter5/demo/data/sales_data.xls'

data = pd.read_excel(filename, index_col ="序号")

data.head(10)数据如下

#数据是类别标签,将它转换为数据

data[data == "好"] = 1

data[data == "是"] = 1

data[data == "高"] = 1

data[data != 1] = -1

x = data.iloc[:,:3].astype(int)

y = data.iloc[:,3].astype(int)astype的用法参考:Python Pandas DataFrame.astype()用法及代码示例 - 纯净天空

#构建基于信息熵的决策树

from sklearn.tree import DecisionTreeClassifier as DTC

dtc = DTC(criterion = "entropy")

dtc.fit(x,y)输出如下:

参数说明如下:

class_weight:类别权重,可选参数,默认是None,也可以字典、字典列表、balanced。指定样本各类别的的权重,主要是为了防止训练集某些类别的样本过多,导致训练的决策树过于偏向这些类别。类别的权重可以通过{class_label:weight}这样的格式给出,这里可以自己指定各个样本的权重,或者用balanced,如果使用balanced,则算法会自己计算权重,样本量少的类别所对应的样本权重会高。当然,如果你的样本类别分布没有明显的偏倚,则可以不管这个参数,选择默认的None。

criterion:特征选择标准,可选参数,默认是gini,可以设置为entropy。gini是基尼不纯度,是将来自集合的某种结果随机应用于某一数据项的预期误差率,是一种基于统计的思想。entropy是香农熵,也就是上篇文章讲过的内容,是一种基于信息论的思想。Sklearn把gini设为默认参数,应该也是做了相应的斟酌的,精度也许更高些?ID3算法使用的是entropy,CART算法使用的则是gini。

splitter:特征划分点选择标准,可选参数,默认是best,可以设置为random。每个结点的选择策略。best参数是根据算法选择最佳的切分特征,例如gini、entropy。random随机的在部分划分点中找局部最优的划分点。默认的”best”适合样本量不大的时候,而如果样本数据量非常大,此时决策树构建推荐”random”。

min_impurity_split:节点划分最小不纯度,可选参数,默认是1e-7。这是个阈值,这个值限制了决策树的增长,如果某节点的不纯度(基尼系数,信息增益,均方差,绝对差)小于这个阈值,则该节点不再生成子节点。即为叶子节点 。

presort:数据是否预排序,可选参数,默认为False,这个值是布尔值,默认是False不排序。一般来说,如果样本量少或者限制了一个深度很小的决策树,设置为true可以让划分点选择更加快,决策树建立的更加快。如果样本量太大的话,反而没有什么好处。问题是样本量少的时候,我速度本来就不慢。所以这个值一般懒得理它就可以了。

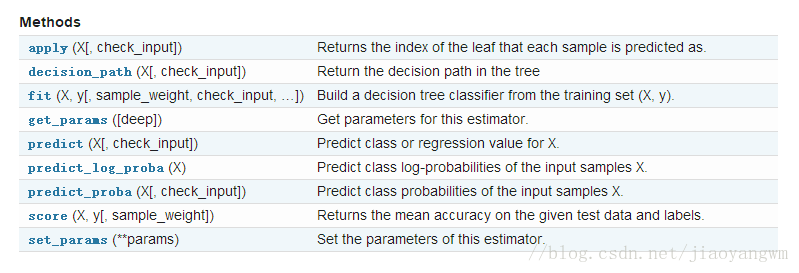

更多说明可见:机器学习实战(三)——决策树_呆呆的猫的博客-程序员宅基地_决策树sklearn.tree.DecisionTreeClassifier()提供了一些方法供我们使用,如下图所示:

#得到模型的平均准确度

dtc.score(x,y)#导入相关函数,可视化决策树

#导出的文件是一个dot文件,需要安装graphviz才能将它转换为pdf等格式

from sklearn.tree import export_graphviz

x = pd.DataFrame(x)

with open("./Python数据分析与挖掘实战(第2版)/chapter5/demo/data/tree.dot","w",encoding='utf-8') as f:

f = export_graphviz(dtc,feature_names = x.columns, out_file =f)安装好graphviz后,在dot所在目录下运行:

$ dot -Tpdf tree.dot -o tree.pdf

如果中文字没法正常显示,可以把原来的

node [shape=box] ;改为

node [shape=box, fontname="Microsoft YaHei"] ;

即可得到生成的结果图

三、C4.5算法与CART算法

C4.5算法与ID3算法相似,但是做了改进,将信息增益比作为选择特征的标准。

关于C4.5对ID3的改进可以看:决策树算法原理(ID3,C4.5) - 做梦当财神 - 博客园

这里主要介绍CART算法。

1.CART分类树

CART分类树预测分类离散型数据,采用基尼指数选择最优特征,同时决定该特征的最优二值切分点。分类过程中,假设有K个类,样本点属于第k个类的概率为Pk,则概率分布的基尼指数定义为

根据基尼指数定义,可以得到样本集合D的基尼指数,其中Ck表示数据集D中属于第k类的样本子集。

如果数据集D根据特征A在某一取值a上进行分割,得到D1,D2两部分后,那么在特征A下集合D的基尼系数如下所示。其中基尼系数Gini(D)表示集合D的不确定性,基尼系数Gini(D,A)表示A=a分割后集合D的不确定性。基尼指数越大,样本集合的不确定性越大。

对于属性A,分别计算任意属性值将数据集划分为两部分之后的Gain_Gini,选取其中的最小值,作为属性A得到的最优二分方案。然后对于训练集S,计算所有属性的最优二分方案,选取其中的最小值,作为样本及S的最优二分方案。

比如:

2.CART回归树

具体例子可以参考:决策树(ID3、C4.5、CART)的原理、Python实现、Sklearn可视化和应用 - 知乎

CART算法在Python中的实现跟前面ID3差不多,不同的是dtc = DTC(criterion = "entropy")中entropy改为gini

三者的区别:

参考:决策树算法原理(CART分类树) - 做梦当财神 - 博客园

四、决策树剪枝

决策树算法本身的执行过程决定了它对训练集的分类是十分精确的,由于考虑到了绝大部分属性,一般都能对训练集中的数据进行比较精确的判断。但是这样所生成的树一般非常复杂,层数较多,有可能将本身并不具显著意义的属性也加以考虑,导致面对未见的新样本时泛化能力较差,产生过拟合问题。因此,有必要在一定程度上降低决策树的复杂度,即消除一些代表性不强的决策路径。即便这样可能会导致模型对训练集的分类精度下降,但决策树的泛化性能会有效提高。

在进行剪枝时,主要有预剪枝和后剪枝两种思路。

预剪枝是指在决策树的生成过程中,对每个节点在划分前先进行评估,若当前的划分不能带来泛化性能的提升,则停止划分,并将当前节点标记为叶节点。

后剪枝是指先从训练集生成一颗完整的决策树,然后自底向上对非叶节点进行考察,若将该节点对应的子树替换为叶节点,能带来泛化性能的提升,则将该子树替换为叶节点。

关于剪枝介绍可以参考:CART决策树原理(分类树与回归树) - 云+社区 - 腾讯云

关于剪枝在Python中的实现可以参考:Python——决策树分类模型剪枝 - 知乎

目前,决策树已演化发展为GBDT、XGBoost等模型:

可以参考:

GBDT的原理、公式推导、Python实现、可视化和应用 - 知乎

XGBoost的原理、公式推导、Python实现和应用 - 知乎

智能推荐

2024最新计算机毕业设计选题大全-程序员宅基地

文章浏览阅读1.6k次,点赞12次,收藏7次。大家好!大四的同学们毕业设计即将开始了,你们做好准备了吗?学长给大家精心整理了最新的计算机毕业设计选题,希望能为你们提供帮助。如果在选题过程中有任何疑问,都可以随时问我,我会尽力帮助大家。在选择毕业设计选题时,有几个要点需要考虑。首先,选题应与计算机专业密切相关,并且符合当前行业的发展趋势。选择与专业紧密结合的选题,可以使你们更好地运用所学知识,并为未来的职业发展奠定基础。要考虑选题的实际可行性和创新性。选题应具备一定的实践意义和应用前景,能够解决实际问题或改善现有技术。

dcn网络与公网_电信运营商DCN网络的演变与规划方法(The evolution and plan method of DCN)...-程序员宅基地

文章浏览阅读3.4k次。摘要:随着电信业务的发展和电信企业经营方式的转变,DCN网络的定位发生了重大的演变。本文基于这种变化,重点讨论DCN网络的规划方法和运维管理方法。Digest: With the development oftelecommunication bussiness and the change of management of telecomcarrier , DCN’s role will cha..._电信dcn

动手深度学习矩阵求导_向量变元是什么-程序员宅基地

文章浏览阅读442次。深度学习一部分矩阵求导知识的搬运总结_向量变元是什么

月薪已炒到15w?真心建议大家冲一冲数据新兴领域,人才缺口极大!-程序员宅基地

文章浏览阅读8次。近期,裁员的公司越来越多今天想和大家聊聊职场人的新出路。作为席卷全球的新概念ESG已然成为当前各个行业关注的最热风口目前,国内官方发布了一项ESG新证书含金量五颗星、中文ESG证书、完整ESG考试体系、名师主讲...而ESG又是与人力资源直接相关甚至在行业圈内成为大佬们的热门话题...当前行业下行,裁员的公司也越来越多大家还是冲一冲这个新兴领域01 ESG为什么重要?在双碳的大背景下,ESG已然成...

对比传统运营模式,为什么越拉越多的企业选择上云?_系统上云的前后对比-程序员宅基地

文章浏览阅读356次。云计算快速渗透到众多的行业,使中小企业受益于技术变革。最近微软SMB的一项研究发现,到今年年底,78%的中小企业将以某种方式使用云。企业希望投入少、收益高,来取得更大的发展机会。云计算将中小企业信息化的成本大幅降低,它们不必再建本地互联网基础设施,节省时间和资金,降低了企业经营风险。科技创新已成时代的潮流,中小企业上云是创新前提。云平台稳定、安全、便捷的IT环境,提升企业经营效率的同时,也为企业..._系统上云的前后对比

esxi网卡直通后虚拟机无网_esxi虚拟机无法联网-程序员宅基地

文章浏览阅读899次。出现选网卡的时候无法选中,这里应该是一个bug。3.保存退出,重启虚拟机即可。1.先随便选择一个网卡。2.勾先取消再重新勾选。_esxi虚拟机无法联网

随便推点

在LaTeX中使用.bib文件统一管理参考文献_egbib-程序员宅基地

文章浏览阅读913次。在LaTeX中,可在.tex文件的同一级目录下创建egbib.bib文件,所有的参考文件信息可以统一写在egbib.bib文件中,然后在.tex文件的\end{document}前加入如下几行代码:{\small\bibliographystyle{IEEEtran}\bibliography{egbib}}即可在文章中用~\cite{}宏命令便捷的插入文内引用,且文章的Reference部分会自动排序、编号。..._egbib

Unity Shader - Predefined Shader preprocessor macros 着色器预处理宏-程序员宅基地

文章浏览阅读950次。目录:Unity Shader - 知识点目录(先占位,后续持续更新)原文:Predefined Shader preprocessor macros版本:2019.1Predefined Shader preprocessor macros着色器预处理宏Unity 编译 shader programs 期间的一些预处理宏。(本篇的宏介绍随便看看就好,要想深入了解,还是直接看Unity...

大数据平台,从“治理”数据谈起-程序员宅基地

文章浏览阅读195次。本文目录:一、大数据时代还需要数据治理吗?二、如何面向用户开展大数据治理?三、面向用户的自服务大数据治理架构四、总结一、大数据时代还需要数据治理吗?数据平台发展过程中随处可见的数据问题大数据不是凭空而来,1981年第一个数据仓库诞生,到现在已经有了近40年的历史,相对数据仓库来说我还是个年轻人。而国内企业数据平台的建设大概从90年代末就开始了,从第一代架构出现到..._数据治理从0搭建

大学抢课python脚本_用彪悍的Python写了一个自动选课的脚本 | 学步园-程序员宅基地

文章浏览阅读2.2k次,点赞4次,收藏12次。高手请一笑而过。物理实验课别人已经做过3、4个了,自己一个还没做呢。不是咱不想做,而是咱不想起那么早,并且仅有的一次起得早,但是哈工大的服务器竟然超负荷,不停刷新还是不行,不禁感慨这才是真正的“万马争过独木桥“啊!服务器不给力啊……好了,废话少说。其实,我的想法很简单。写一个三重循环,不停地提交,直到所有的数据都accepted。其中最关键的是提交最后一个页面,因为提交用户名和密码后不需要再访问其..._哈尔滨工业大学抢课脚本

english_html_study english html-程序员宅基地

文章浏览阅读4.9k次。一些别人收集的英文站点 http://www.lifeinchina.cn (nice) http://www.huaren.us/ (nice) http://www.hindu.com (okay) http://www.italki.com www.talkdatalk.com (transfer)http://www.en8848.com.cn/yingyu/index._study english html

Cortex-M3双堆栈MSP和PSP_stm32 msp psp-程序员宅基地

文章浏览阅读5.5k次,点赞19次,收藏78次。什么是栈?在谈M3堆栈之前我们先回忆一下数据结构中的栈。栈是一种先进后出的数据结构(类似于枪支的弹夹,先放入的子弹最后打出,后放入的子弹先打出)。M3内核的堆栈也不例外,也是先进后出的。栈的作用?局部变量内存的开销,函数的调用都离不开栈。了解了栈的概念和基本作用后我们来看M3的双堆栈栈cortex-M3内核使用了双堆栈,即MSP和PSP,这极大的方便了OS的设计。MSP的含义是Main..._stm32 msp psp