”激活函数“ 的搜索结果

GELU (Gaussian Error Linear Units) 是一种基于高斯误差函数的激活函数,相较于 ReLU 等激活函数,GELU 更加平滑,有助于提高训练过程的收敛速度和性能。GELU是一种常见的激活函数,全称为“Gaussian Error Linear ...

ReLU(Rectified Linear Unit)激活函数是一种常用的非线性激活函数,其原理是在输入小于等于零时输出为零,在输入大于零时输出等于输入值。ReLU激活函数的作用是引入非线性变换,使得神经网络可以学习更复杂的模式...

21种激活函数的对比

标签: 激活函数

激活函数描述和对比,帮助了解激活函数的效果和作用。

列举四种神经网络激活函数的函数公式、函数图及优缺点和适用场景

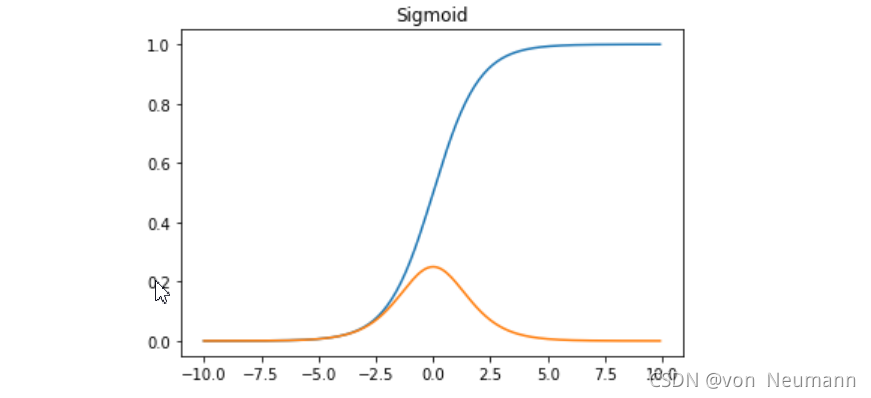

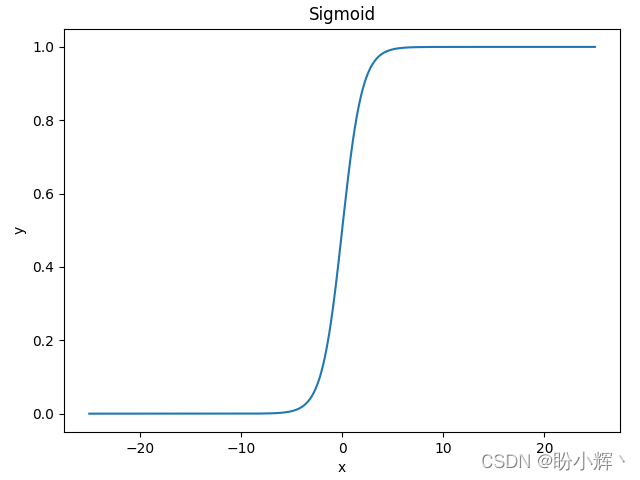

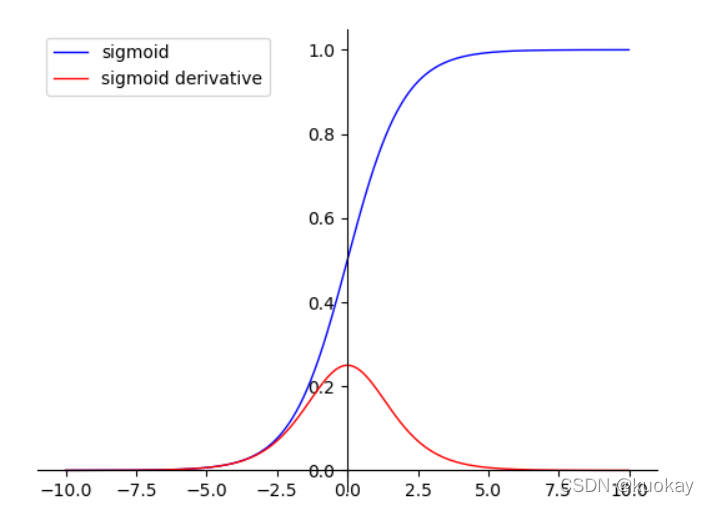

激活函数是神经网络中的重要组成部分,它决定了神经元的输出。在神经网络的前向传播中,输入数据被传递给神经元,经过加权和和激活函数的计算后,得到神经元的输出。 本文将介绍几种常见的激活函数,它们的定义、...

激活函数通过增加非线性变换,使得神经网络能够学习和表示更加复杂的函数关系,提高模型的拟合能力和表达能力。总之,激活函数在计算机视觉中的作用、原理和意义是通过引入非线性变换,增加网络的表达能力,激活神经...

神经网络的激活函数总结

标签: 人工智能 机器学习

激活函数在神经网络中具有重要的地位。在SIGAI之前的公众号文章“理解神经网络的激活函数”中,我们回答了3个关键的问题: 为什么需要激活函数? 什么样的函数能用作激活函数? 什么样的函数是好的激活函数? 这...

LeakyReLU激活函数

标签: pytorch

是PyTorch中的Leaky Rectified Linear Unit(ReLU)激活函数的实现。Leaky ReLU是一种修正线性单元,它在非负数部分保持线性,而在负数部分引入一个小的斜率(通常是一个小的正数),以防止梯度消失问题。:x为负数...

深度学习中的激活函数导引 我爱机器学习(52ml.net)2016年8月29日0 作者:程程 链接:https://zhuanlan.zhihu.com/p/22142013 来源:知乎 著作权归作者所有,已联系作者获得转载许可。 深度学习大...

本文介绍了一些常用的激活函数,包括:Sigmoid、Tanh、ReLU、Leaky ReLU、PReLU、 Swish等激活函数及其在当前激活函数众多的情况下使用的环境。总体而言:ReLU激活函数还是最常用的激活函数。

1. 什么是激活函数? 所谓激活函数(Activation Function),就是在人工神经网络的神经元上运行的函数,负责将神经元的输入映射到输出端。然后这里也给出维基百科的定义:在计算网络中, 一个节点的激活函数...

推荐文章

- 回溯法解01背包问题(最通俗易懂,附C++代码)_回溯法解决01背包问题-程序员宅基地

- Apache孵化器主席Justin Mclean:如何成为Apache顶级开源项目_apache基金会项目申请-程序员宅基地

- 遇到BASE64的图片字符串应该如何转换成图片呢_go语言把base64转换成图片格式-程序员宅基地

- (转)基于MVC4+EasyUI的Web开发框架经验总结(10)--在Web界面上实现数据的导入和导出...-程序员宅基地

- 14.JS语句和注释,变量和数据类型-程序员宅基地

- C语言ASCLL码_c语言 \ ascll-程序员宅基地

- Linux那些事儿之我是U盘(37)彼岸花的传说(五)_unsigned soft : 1;-程序员宅基地

- usb-serial controller d感叹号_usb serial converter驱动感叹号-程序员宅基地

- Laravel定时任务_laravel 停止schedule:run-程序员宅基地

- LeetCode刷题—树的遍历(前中后序、层次)_leetcod遍历一棵树-程序员宅基地