”激活函数“ 的搜索结果

网格搜索神经网络超参数:激活函数(案例+源码)

学好 Python 不论是就业还是做副业赚钱都不错,但要学会 Python 还是要有一个学习规划。最后大家分享一份全套的 Python 学习资料,给那些想学习 Python 的小伙伴们一点帮助!

深度学习基础笔记——激活函数

标签: 深度学习

1.relu是分段函数2.relu本质上是分段线性激活函数,但可以不断分段逼近非线性激活函数当该网络足够复杂时,理论上relu可以逼近任意非线性激活函数。

PyTorch、人工智能、深度学习、激活函数

激活函数大全 目前没有一个完整的来源包含其详尽的概述。即使在我们的经验中,缺乏这一概述也会导致冗余和对现有激活功能的无意重新发现。为了弥补这一差距,我们的论文进行了一项涉及400个激活函数的广泛调查,其...

ReLU激活函数相对于Sigmoid和Tanh激活函数的优点是什么?ReLU它有局限性吗?如何改进?

[选择CNN激活函数:ReLU、Sigmoid还是Tanh?优缺点对比解读](https://pic3.zhimg.com/80/v2-ea4bf692fc12aad56fdb71cd3c4ccc52_1440w.webp) # 1. 了解CNN激活函数 在深度学习中,激活函数扮演着至关重要的角色,...

一切皆是映射:神经网络中的激活函数深度解析 1. 背景介绍 1.1 神经网络的重要性 神经网络已经成为当今人工智能领域最重要和最广泛使用的技术之一。它们在计算机视觉、自然语言处理、语音识别等诸多领域展现出卓越的...

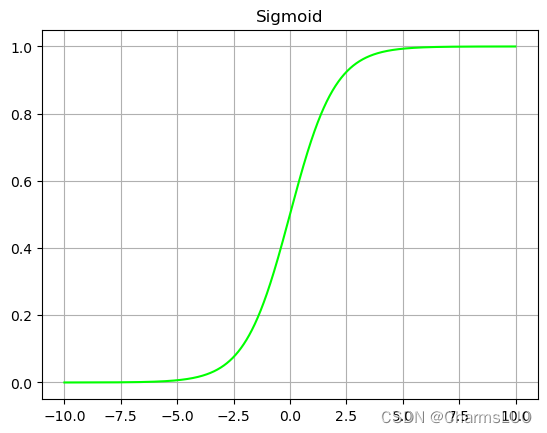

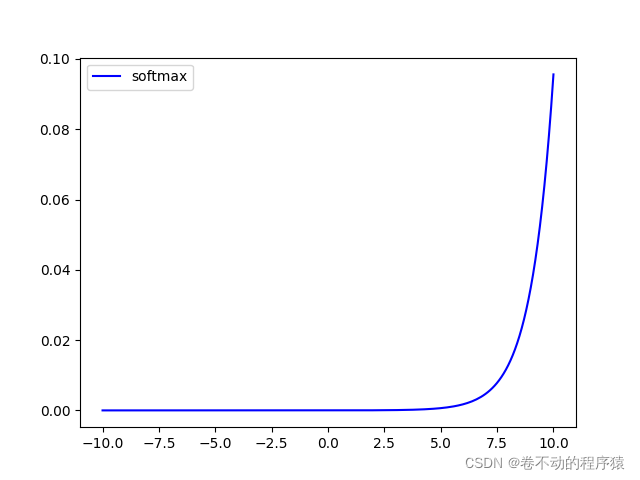

激活函数具有的特性激活函数的类别饱和激活函数Sigmoid激活函数Tanh(双曲正切函数)激活函数Sigmoid、Tanh激活函数引发的常见问题解决非饱和激活函数ReLU激活函数Leaky ReLU等变种激活函数 为什么要使用激活函数? ...

在看到激活函数的时候,突然不知道激活函数是干嘛用的!立马翻遍手里的纸质资料,都说的模糊不清。无奈,赶紧来网上看看!下面,我就把在网上看到的知识点,总结一下,形成读书笔记,方便大家学习!由于本人知识有限...

激活函数和损失函数在深度学习中起着不可或缺的作用。通过合理选择和设计激活函数和损失函数,可以提高神经网络的性能和泛化能力,使其在各种任务中取得更好的效果。因此,深度学习领域对于激活函数和损失函数的研究...

1.背景介绍 神经网络是人工智能领域的一种重要技术,它由多个节点(神经元)...在这篇文章中,我们将讨论激活函数的激活函数,即实现不同行为的神经网络。我们将从以下几个方面进行讨论: 背景介绍 核心概念与联系...

fxx∗σxfxx∗σxσx11e−xσx1e−x1正数区域内,SiLU 函数的输出与 ReLU 函数的输出相同。在负数区域内,SiLU 函数的输出与 sigmoid 函数的输出相同。SiLU 函数在整个定义域内都是可微的,这使得在反向传播过程中...

激活函数在神经网络中具有重要的地位,对于常用的函数如sigmoid,tanh,ReLU,不少读者都已经非常熟悉。但是你是否曾想过这几个问题: 为什么需要激活函数? 什么样的函数可以做激活函数? 什么样的函数是好的...

【翻译自 : How to Choose an Activation Function for Deep Learning】 ... 输出层中激活函数的选择将定义模型可以做出的预测类型。因此,必须为每个深度学习神经网络项目仔细选择激活函数。 ...

推荐文章

- Chapter4 The Relational Model_order pairs and cartesian product-程序员宅基地

- java检查手机号是否被注册_【java】如何开发一个检测手机号注册过哪些网站的应用?...-程序员宅基地

- Android 插件化-程序员宅基地

- 最新阿里内推 Java 后端面试题_索引会不会使插入、删除作效率变低,怎么解决?-程序员宅基地

- Redis实现延迟队列方法介绍-程序员宅基地

- Python入门实战:Python的文件操作-程序员宅基地

- 机器学习模型对比_机器学习的模型比较-程序员宅基地

- 纯C语言完整代码操作单链表(初始化、插入、删除、查找...)-程序员宅基地

- 实战打靶集锦-027-SoSimple1_sosimple 写入试验场-程序员宅基地

- 用opencv的dnn模块做yolov5目标检测_opencv yolov5-程序员宅基地