”激活函数“ 的搜索结果

激活函数(activation function)运行时激活神经网络中某一部分神经元,将激活神经元的信息输入到下一层神经网络中。神经网络之所以能处理非线性问题,这归功于激活函数的非线性表达能力。激活函数需要满足数据的输入...

深度学习-激活函数总结

标签: 深度学习

激活函数之ReLU, GeLU, SwiGLU

Datawhale干货作者:Sukanya Bag,来源:机器之心激活函数是神经网络模型重要的组成部分,本文作者Sukanya Bag从激活函数的数学原理出发,详解了十种激活函数的优缺...

基于matlab的人工神经网络激活函数示例基于matlab的人工神经网络激活函数示例

1. 自定义激活函数 首先,您需要使用 backend定义一个函数。 例如,这是我实现swish激活功能的方式 from keras import backend as K def swish(x, beta=1.0): return x * K.sigmoid(beta * x) 如果要将字符串...

神经网络中的激活函数系列文章: 激活函数是神经网络中非常重要的东西,作用不亚于卷积。激活函数是为了模拟神经元的激活和抑制状态的一个组件,自然界的神经活动都是通过一部分神经元的激活,一部分神经元受到...

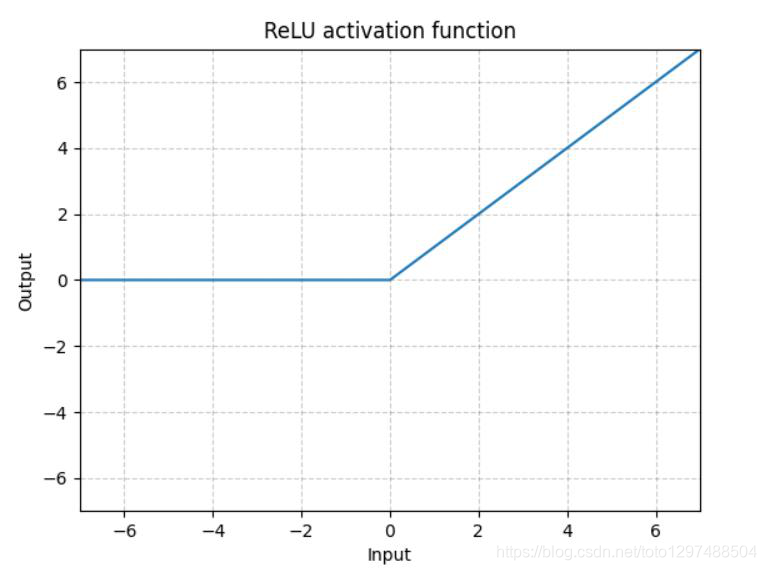

激活函数的作用 激活函数的主要作用就是加入非线性因素,以解决线性模型表达能力不足的缺陷,在整个神经网络起到至关重要的作用。在神经网络中常用的激活函数有Sigmoid、Tanh和relu等。 二 Sigmod函数 1 函数介绍 ...

主要对比分析了神经网络各种激活函数的优缺点。

本文首发于我的个人博客: 激活函数:...激活函数之性质 1. 非线性:即导数不是常数。保证多层网络不退化成单层线性网络。这也是激活函数的意义所在。 2. 可微性:保证了在优化中梯度的可计算性。虽...

激活函数

Softmax激活函数

标签: pytorch

在多分类问题中,我们通常回使用softmax函数作为网络输出层的激活函数,softmax函数可以对输出值进行归一化操作,把所有输出值都转化为概率,所有概率值加起来等于1,softmax的公式为 简单的Softmax计算例子 ...

用matlab画常见的三种激活函数代码

推荐文章

- 用好ASP.NET 2.0的URL映射-程序员宅基地

- C语言等级考试是把题目删了,历年全国计算机的等级考试二级C语言上机考试地训练题目库及答案详解(72页)-原创力文档...-程序员宅基地

- Microsoft Office显示正在更新无法打开的问题_正在更新microsoft 365和office-程序员宅基地

- 非常好的Ansible入门教程(超简单)-程序员宅基地

- 【Gradle-8】Gradle插件开发指南-程序员宅基地

- 使用PL/SQL Developer软件解锁_plsqldev表格锁怎么打开-程序员宅基地

- 【Windows Server 2019】Web服务 IIS 配置与管理——配置 IIS 进阶版 Ⅳ_iis默认路径-程序员宅基地

- 网络中的各层协议_发送消息时各层协议-程序员宅基地

- UCRT: VC 2015 Universal CRT, by Microsoft_vc15rt-程序员宅基地

- 关于EntityFramework 7 开发学习_entiry framework 7 书籍-程序员宅基地